게시일: 2024년 5월 14일, 최종 업데이트: 2024년 5월 20일

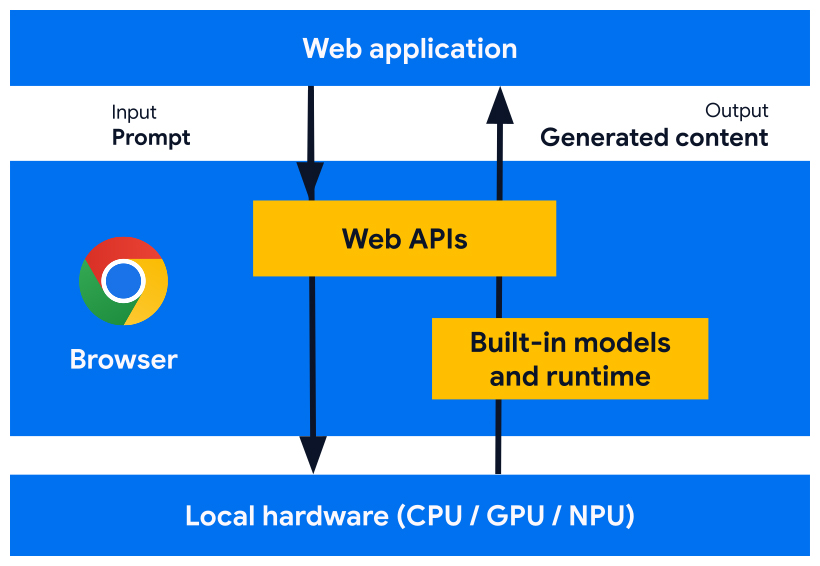

Google에서는 브라우저에 내장된 AI 모델, 전문가 모델, 대규모 언어 모델 (LLM)과 함께 작동하도록 설계된 웹 플랫폼 API와 브라우저 기능을 개발하고 있습니다. 기본 제공 AI를 사용하면 모델을 배포, 관리 또는 자체 호스팅할 필요 없이 웹사이트나 웹 애플리케이션에서 AI 기반 작업을 실행할 수 있습니다.

내장 AI의 이점, Google의 구현 계획, 이러한 도구를 구현하는 방법을 알아보세요.

웹에서 AI를 처음 사용하는 경우 웹 AI 용어집 및 개념을 참고하세요.

웹 개발자를 위한 내장 AI의 이점

브라우저에는 AI가 내장되어 있어 기반 모델과 전문가 모델을 제공하고 관리합니다.

내장 AI는 다음과 같은 이점을 제공합니다.

- 배포 용이성: 브라우저가 기기 기능을 고려하여 모델을 배포하고 업데이트를 관리합니다. 즉, 네트워크를 통해 대규모 모델을 다운로드하거나 업데이트할 필요가 없습니다. 스토리지 삭제, 런타임 메모리 예산, 제공 비용 및 기타 문제를 해결할 필요가 없습니다.

- 하드웨어 가속 액세스: 브라우저의 AI 런타임은 GPU, NPU 또는 CPU로 대체되는 등 사용 가능한 하드웨어를 최대한 활용하도록 최적화되어 있습니다. 따라서 앱은 각 기기에서 최상의 성능을 얻을 수 있습니다.

클라이언트 측 실행의 이점

내장 AI를 사용하면 AI를 클라이언트 측에서 실행할 수 있으므로 다음과 같은 이점이 있습니다.

- 민감한 정보의 로컬 처리: 클라이언트 측 AI는 개인 정보 보호 스토리를 개선할 수 있습니다. 예를 들어 민감한 데이터를 사용하는 경우 엔드 투 엔드 암호화를 통해 사용자에게 AI 기능을 제공할 수 있습니다.

- 빠른 사용자 환경: 서버로의 왕복을 없애면 거의 즉각적인 결과를 제공할 수 있는 경우가 있습니다. 클라이언트 측 AI는 실행 가능한 기능과 최적화되지 않은 사용자 환경을 구분할 수 있습니다.

- AI에 대한 액세스 권한 확대: 사용자의 기기가 기능에 대한 액세스 권한을 더 많이 제공하는 대신 처리 부하를 일부 부담할 수 있습니다. 예를 들어 프리미엄 AI 기능을 제공하는 경우 클라이언트 측 AI로 이러한 기능을 미리 볼 수 있도록 하여 잠재 고객이 추가 비용 없이 제품의 이점을 확인할 수 있습니다. 이 하이브리드 접근 방식은 특히 자주 사용되는 사용자 흐름에서 추론 비용을 관리하는 데도 도움이 됩니다.

- 오프라인 AI 사용: 인터넷에 연결되어 있지 않아도 사용자가 AI 기능에 액세스할 수 있습니다. 즉, 사이트와 웹 앱이 오프라인 상태이거나 연결이 불안정한 상태에서도 예상대로 작동할 수 있습니다.

하이브리드 AI: 클라이언트 측 및 서버 측

클라이언트 측 AI는 다양한 사용 사례를 처리할 수 있지만 일부 사용 사례에는 서버 측 지원이 필요합니다. 서버 측 AI는 대규모 모델에 적합하며 더 광범위한 플랫폼과 기기를 지원할 수 있습니다.

애플리케이션에 다음이 필요한 경우 하이브리드 접근 방식을 고려할 수 있습니다.

- 복잡성: 구체적이고 접근 가능한 사용 사례는 온디바이스 AI로 지원하기가 더 쉽습니다. 복잡한 사용 사례의 경우 서버 측 구현을 고려하세요.

- 복원력: 기본적으로 서버 측을 사용하고 기기가 오프라인 상태이거나 연결 상태가 좋지 않을 때는 온디바이스를 사용합니다.

- 그레이스풀 폴백: AI가 내장된 브라우저를 도입하는 데는 시간이 걸리며, 일부 모델은 사용하지 못할 수 있고, 오래되었거나 성능이 낮은 기기는 모든 모델을 최적으로 실행하기 위한 하드웨어 요구사항을 충족하지 못할 수 있습니다. 이러한 사용자에게 서버 측 AI를 제공합니다.

예를 들어 내장 프롬프트 API를 사용하는 경우 API는 Windows, macOS, Linux의 Chrome 확장 프로그램에서만 사용할 수 있습니다. 모든 사용자가 AI 기능을 활용할 수 있도록 Firebase AI Logic을 사용하여 하이브리드 아키텍처를 설정하세요.

기본 제공 AI 액세스

주로 Translator API 또는 Summarizer API와 같은 작업 API를 사용하여 내장 AI 기능에 액세스할 수 있습니다. 작업 API는 언어 모델이든 전문가 모델이든 과제에 가장 적합한 모델에 대해 추론을 실행하도록 설계되었습니다.

내장 AI를 사용해야 하는 경우

다음은 내장 AI가 나와 사용자에게 도움이 되는 몇 가지 방법입니다.

- AI 기반 콘텐츠 소비: 요약, 번역, 분류, 특성 부여, 지식 제공자 등의 기능이 포함됩니다.

- AI 지원 콘텐츠 제작: 글쓰기 도우미, 교정, 문법 수정, 바꿔쓰기 등

기본 제공 AI API 중 일부는 Chrome 안정화 버전과 오리진 트라이얼에서 사용할 수 있습니다. 탐색적 API와 초기 단계 API는 사전 체험 프로그램 (EPP) 참여자에게 제공됩니다.

새 기능 미리보기

Google에서는 사용 사례를 충족하는 API를 구성하고 표준화를 위해 다른 브라우저 공급업체와의 논의에 정보를 제공하기 위해 여러분의 의견이 필요합니다.

EPP에 참여하여 초기 단계의 기본 제공 AI 아이디어에 관한 의견을 제공하고 로컬 프로토타입을 통해 진행 중인 API를 테스트할 기회를 알아보세요.

표준화 노력

Google에서는 브라우저 간 호환성을 위해 이러한 모든 API를 표준화하기 위해 노력하고 있습니다.

Language Detector API와 Translator API는 W3C WebML Working Group에서 채택했습니다. Mozilla 및 WebKit에 표준 입장을 문의했습니다.

Summarizer API, Writer API, Rewriter API도 W3C WebML 작업 그룹에서 채택했습니다. Google에서는 Mozilla와 WebKit에 표준 입장을 문의했습니다.