Veröffentlicht: 20. Mai 2025

Um den Anforderungen Ihrer Nutzer gerecht zu werden, unabhängig davon, welche Plattform oder Hardware sie verwenden, können Sie mit Firebase AI Logic für die integrierte Prompt API ein Fallback zur Cloud einrichten.

Hybride KI-Lösung entwickeln

Integrierte KI bietet eine Reihe von Vorteilen, insbesondere:

- Lokale Verarbeitung vertraulicher Daten:Wenn Sie mit vertraulichen Daten arbeiten, können Sie Nutzern KI-Funktionen mit Ende-zu-Ende-Verschlüsselung anbieten.

- KI-Nutzung im Offlinemodus:Ihre Nutzer können auf KI-Funktionen zugreifen, auch wenn sie offline sind oder die Verbindung unterbrochen wurde.

Diese Vorteile gelten zwar nicht für Cloud-Anwendungen, Sie können aber für Nutzer, die keinen Zugriff auf integrierte KI haben, für eine reibungslose Nutzung sorgen.

Erste Schritte mit Firebase

- Erstellen Sie ein Firebase-Projekt und registrieren Sie Ihre Webanwendung.

- Lesen Sie die Dokumentation zum Firebase JavaScript SDK, um die Einrichtung Ihrer Webanwendung fortzusetzen.

Bei Firebase-Projekten wird ein Google Cloud-Projekt mit Firebase-spezifischen Konfigurationen und Diensten erstellt. Weitere Informationen zu Google Cloud und Firebase

SDK Installieren

Dieser Workflow verwendet npm und erfordert Modul-Bundler oder Tools für JavaScript-Frameworks. Firebase AI Logic ist für die Verwendung mit Modul-Bundlern optimiert, um ungenutzten Code zu entfernen und die SDK-Größe zu verringern.

npm install firebase

Nach der Installation initialisieren Sie Firebase in Ihrer Anwendung.

Firebase AI Logic verwenden

Nachdem Firebase installiert und initialisiert wurde, wählen Sie entweder die Gemini Developer API oder die Vertex AI Gemini API aus und initialisieren und erstellen Sie eine Instanz.

Nach der Initialisierung können Sie das Modell mit Text- oder multimodalen Eingaben auffordern.

Text-Prompts

Sie können Klartext für Ihre Anweisungen an das Modell verwenden. Sie könnten das Modell beispielsweise bitten, Ihnen einen Witz zu erzählen.

Sie haben verschiedene Möglichkeiten, wie die Anfrage weitergeleitet wird:

Wenn die integrierte KI verfügbar ist, können Sie sie standardmäßig verwenden, indem Sie

modein der FunktiongetGenerativeModel()auf'prefer_on_device'setzen. Wenn das integrierte Modell nicht verfügbar ist, wird die Anfrage nahtlos auf das Cloud-Modell zurückgesetzt (wenn Sie online sind).Verwenden Sie das Cloud-Modell standardmäßig, wenn Sie online sind, indem Sie

modein der FunktiongetGenerativeModel()auf'prefer_in_cloud'setzen. Wenn Sie offline sind, wird die Anfrage nahtlos an die integrierte KI weitergeleitet, sofern verfügbar.

// Initialize the Google AI service.

const googleAI = getAI(firebaseApp);

// Create a `GenerativeModel` instance with a model that supports your use case.

const model = getGenerativeModel(googleAI, { mode: 'prefer_on_device' });

const prompt = 'Tell me a joke';

const result = await model.generateContentStream(prompt);

for await (const chunk of result.stream) {

const chunkText = chunk.text();

console.log(chunkText);

}

console.log('Complete response', await result.response);

Multimodale Prompts

Sie können auch Bilder oder Audioinhalte als Prompts verwenden. Sie können das Modell beispielsweise bitten, den Inhalt eines Bildes zu beschreiben oder eine Audiodatei zu transkribieren.

Bilder müssen als Base64-codierter String als Firebase-FileDataPart-Objekt übergeben werden. Dazu können Sie die Hilfsfunktion fileToGenerativePart() verwenden.

// Converts a File object to a `FileDataPart` object.

// https://firebase.google.com/docs/reference/js/vertexai.filedatapart

async function fileToGenerativePart(file) {

const base64EncodedDataPromise = new Promise((resolve) => {

const reader = new FileReader();

reader.onload = () => resolve(reader.result.split(',')[1]);

reader.readAsDataURL(file);

});

return {

inlineData: { data: await base64EncodedDataPromise, mimeType: file.type },

};

}

const fileInputEl = document.querySelector('input[type=file]');

fileInputEl.addEventListener('change', async () => {

const prompt = 'Describe the contents of this image.';

const imagePart = await fileToGenerativePart(fileInputEl.files[0]);

// To generate text output, call generateContent with the text and image

const result = await model.generateContentStream([prompt, imagePart]);

for await (const chunk of result.stream) {

const chunkText = chunk.text();

console.log(chunkText);

}

console.log(Complete response: ', await result.response);

});

Demo

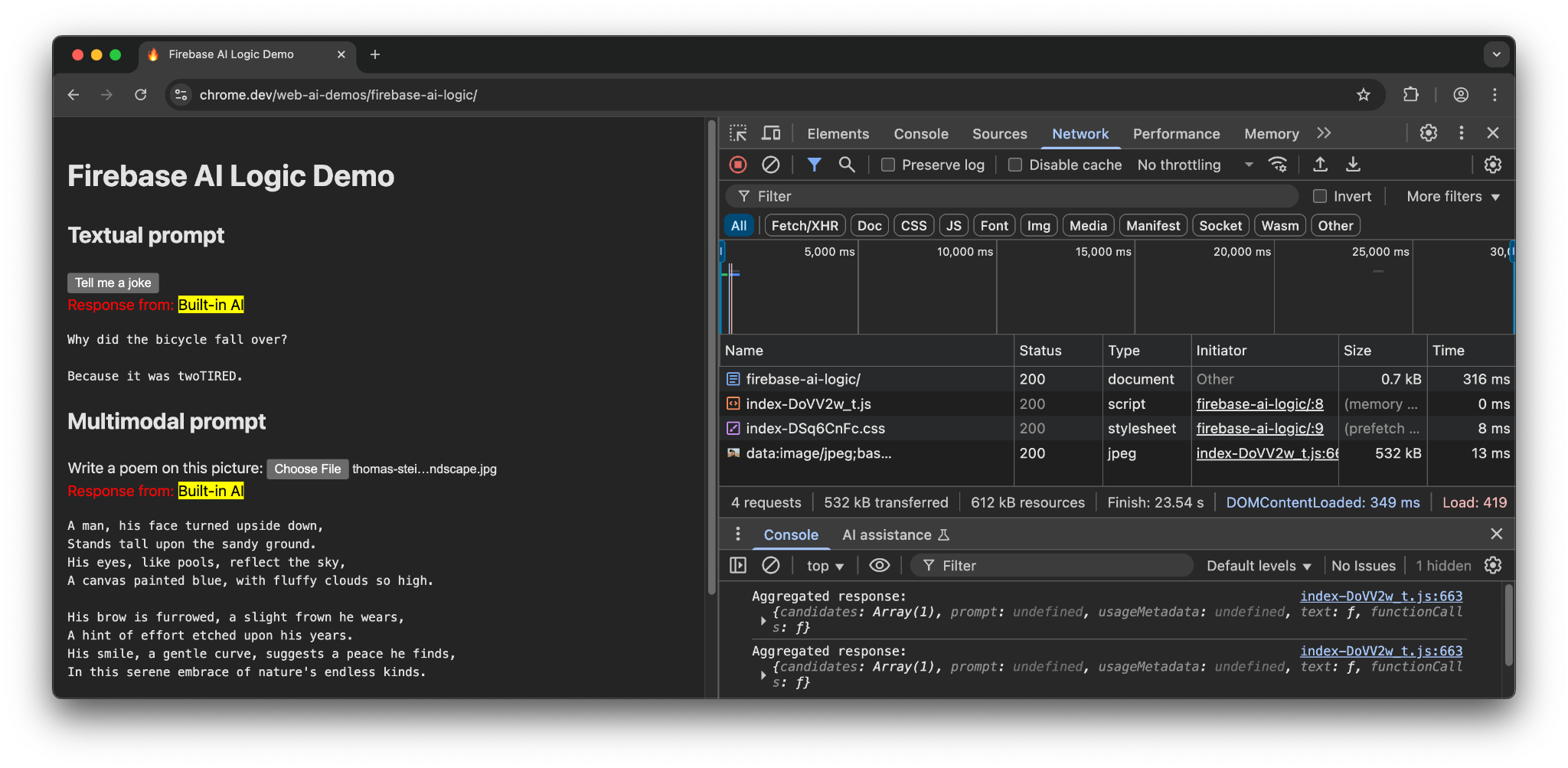

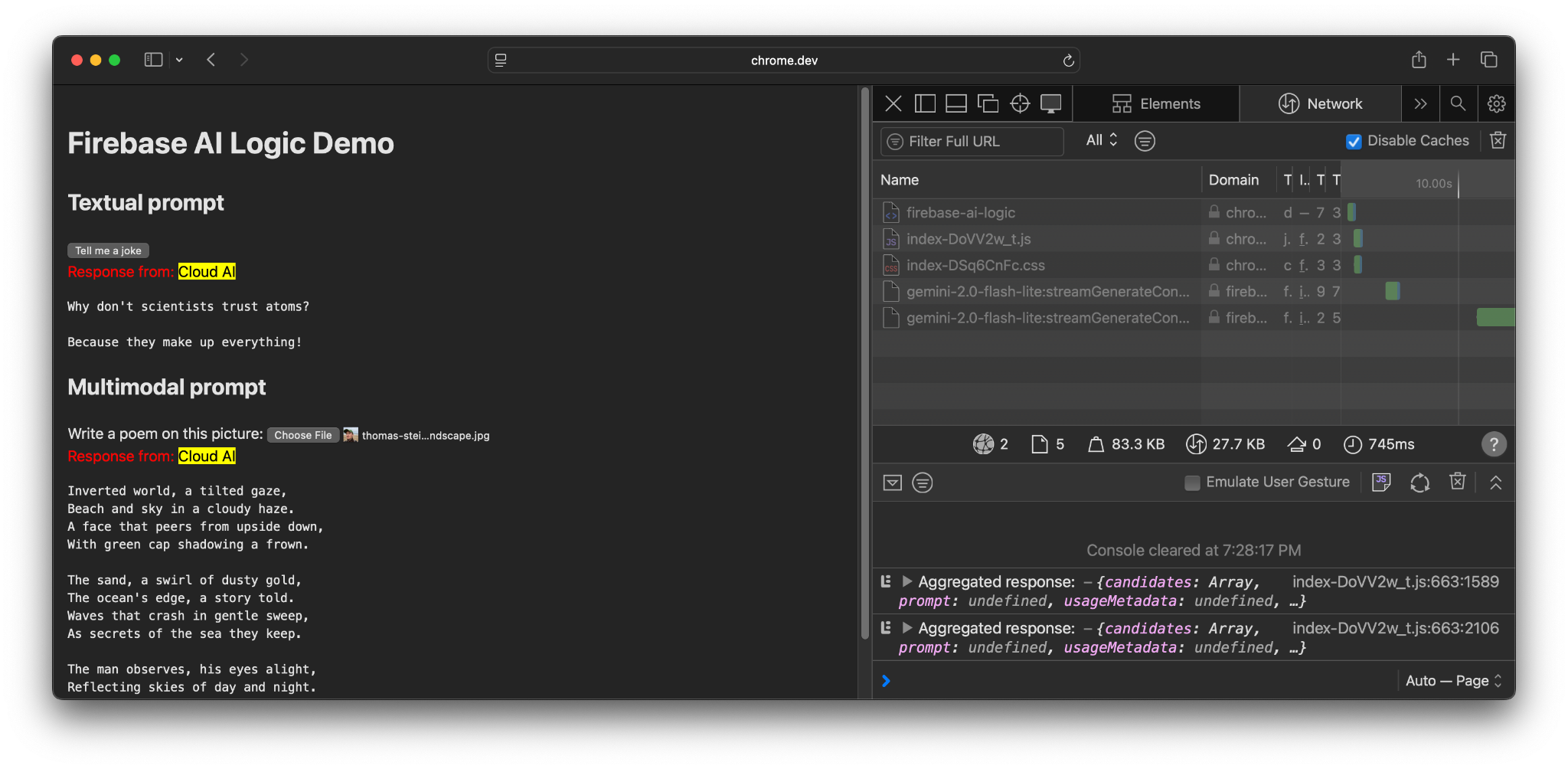

Rufen Sie die Firebase AI Logic-Demo auf verschiedenen Geräten und in verschiedenen Browsern auf. Sie können sehen, ob die Modellantwort vom integrierten KI-Modell oder aus der Cloud stammt.

Auf unterstützter Hardware in Chrome verwendet die Demo die Prompt API und Gemini Nano. Es werden nur drei Anfragen für das Hauptdokument, die JavaScript-Datei und die CSS-Datei gestellt.

Wenn Sie einen anderen Browser oder ein Betriebssystem ohne integrierte KI-Unterstützung verwenden, wird eine zusätzliche Anfrage an den Firebase-Endpunkt https://firebasevertexai.googleapis.com gesendet.

Teilnehmen und Feedback geben

Firebase AI Logic kann eine gute Option sein, um KI-Funktionen in Ihre Web-Apps zu integrieren. Durch die Bereitstellung eines Fallbacks in der Cloud, wenn die Prompt API nicht verfügbar ist, sorgt das SDK für eine bessere Zugänglichkeit und Zuverlässigkeit von KI-Funktionen.

Cloudanwendungen schaffen neue Erwartungen an Datenschutz und Funktionalität. Daher ist es wichtig, Ihre Nutzer darüber zu informieren, wo ihre Daten verarbeitet werden.

- Wenn Sie Feedback zur Implementierung von Chrome geben möchten, melden Sie einen Fehler oder stellen Sie eine Anfrage zu einem Feature.

- Wenn Sie Feedback zu Firebase AI Logic geben möchten, reichen Sie einen Fehlerbericht ein.